Es gibt sicher viele Möglichkeiten Verzeichnisse zu synchronisieren. Unter OS X kann man es einerseits direkt über das Terminal mit rsync erledigen, oder auch per Automator ein entsprechendes Skript erstellen. Alternativ gibt es arRsync – eine grafische Benutzeroberfläche für rsync die ich auch empfehlen kann.

Es gibt sicher viele Möglichkeiten Verzeichnisse zu synchronisieren. Unter OS X kann man es einerseits direkt über das Terminal mit rsync erledigen, oder auch per Automator ein entsprechendes Skript erstellen. Alternativ gibt es arRsync – eine grafische Benutzeroberfläche für rsync die ich auch empfehlen kann.

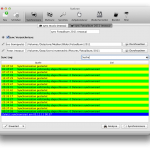

Wenn man zwei oder mehr Verzeichnisse synchron halten, will lernt man von der Time Machine, dass automatische und häufige Synchronisation ein wichtiger Bestandteil sind.  Nur wenn alles ohne Zutun unauffällig im Hintergrund läuft wird es wohl auf Dauer funktionieren. Synkron ist ein kleines Tool, dass neben der Synchronisation auch einen Aufgabenplaner enthält. Es ist schlank und enthält alle wichtigen Funktionen. Zum schnellen Einstieg empfiehlt sich das Video-Tutorial.

Nur wenn alles ohne Zutun unauffällig im Hintergrund läuft wird es wohl auf Dauer funktionieren. Synkron ist ein kleines Tool, dass neben der Synchronisation auch einen Aufgabenplaner enthält. Es ist schlank und enthält alle wichtigen Funktionen. Zum schnellen Einstieg empfiehlt sich das Video-Tutorial.

Außerdem ist Synkron unter OS X, Linux und Windows verfügbar. Ich verwende es um Bilder und Musik zwischen meinen Rechnern und dem Synology NAS zu synchronisieren – stündlich. Wenn sich nichts geändert hat sind es nur ein paar Sekunden die das Programm im Hintergrund benötigt.

Die Synchronisation von iTunes-Mediatheken ist ein Thema über das viel im Netz zu lesen ist, eine wirklich schmerzfreie Lösung konnte ich nicht finden. iCloud bzw. konkret iTunes Match wäre wohl eine solche Lösung – auch für schon vorhandene Musik – aber darauf wird man in Deutschland noch länger warten müssen als ich ohne auskommen möchte.  Aktuell scheint mir Tune-Instructor (nur OS X) ein sehr gutes Tool, um die iTunes-Mediathek über neue Inhalte zu informieren. Dies kann allerdings nur manuell durchgeführt werden und nicht über einen Aufgabenplaner. Zum Hintergrund: iTunes erkennt nicht automatisch wenn Inhalte aus der Mediathek hinzugefüht, gelöscht oder verändert wurden. Dies ist allerdings bei der Synchronisation der Dateien immer der Fall. Tune-Instructor aktualisiert die Mediathek entsprechend. Tune-Instructor hat noch einige nette Eigenschaften und lohnt sich damit doppelt.

Aktuell scheint mir Tune-Instructor (nur OS X) ein sehr gutes Tool, um die iTunes-Mediathek über neue Inhalte zu informieren. Dies kann allerdings nur manuell durchgeführt werden und nicht über einen Aufgabenplaner. Zum Hintergrund: iTunes erkennt nicht automatisch wenn Inhalte aus der Mediathek hinzugefüht, gelöscht oder verändert wurden. Dies ist allerdings bei der Synchronisation der Dateien immer der Fall. Tune-Instructor aktualisiert die Mediathek entsprechend. Tune-Instructor hat noch einige nette Eigenschaften und lohnt sich damit doppelt.

Ich bin gespannt wie lange diese halbautomatische Lösung funktioniert. Vielleicht wird das alles ja bald von iCloud abgelöst?

Schlagwort-Archive: Backup

Buffalo NAS Update für OS X / Lion

Nicht wirklich viel neues gibt es von Buffalotech – zumindest was mein NAS Laufwerk betrifft. Im Vergleich zu manch anderen, wie Synology, sind die Informationen eher spärlich. Zum Glück kommt der Hersteller in den letzten Tagen immer mehr unter Druck (siehe diesen Post im Forum) Informationen zu veröffentlichen für welche Produkte es bis wann aktualisierte Firmware geben wird. Das wäre ja das mindeste…

Timemachine mit Buffalo NAS unter Lion

Das aktuelle OS-X Betriebssystem Lion verdirbt vielen NAS-Benutzern den Spaß. Apple verlangt mit dem aktuellen Lion Release die Version 2.2. von NetAFP Netatalk. Beim Versuch einer Verbindung zum NAS (bei mir eine Buffalo Linkstation Pro Duo, LS-WTGL/R1-V3 F/W 3.09) erhält man folgende Meldung:

“There was a problem connecting to the server” The version of the server you are trying to connect to is not supported (…)

Details bei Macwelt:

Kein von Macwelt bisher getestetes Netzlaufwerk erfüllt komplett diese Spezifikationen, da die Hersteller Open-Source-Versionen von AFP verwenden, die nicht alle erforderlichen Funktionen beinhalten. Bisher stellte dies aber kein Problem dar, da Time Machine trotzdem mit den Laufwerken zusammengearbeitet und nur eine Warnung in die Log-Datei geschrieben hat.

Um auf NAS-Laufwerke mit bestehender Firmware weiterhin zugreifen zu können benötigt man einen Workarround den man bei Alexander Wilde findet. Time Machine verweigert aber weiterhin den Zugriff, womit keine Backups möglich sind. In diesem Fall muss man wohl auf ein Update der Firmware vom Hersteller warten.

Folgende Befehle müssen über das Terminal abgesetzt werden:

sudo chmod o+w /Library/Preferences defaults write /Library/Preferences/com.apple.AppleShareClient afp_host_prefs_version -int 1

Danach muss der Computer neu gestartet werden. In Finder versucht man nun ein AFP Laufwerk zu verbinden (CMD + K oder klick auf den bisherige NAS-Verbindung). Das Funktioniert noch nicht, allerdings wird dabei eine benötigte Konfigurationsdatei angelegt. Nun gibt man einen weiteren Befehl im Terminal ein:

sudo defaults write /Library/Preferences/com.apple.AppleShareClient afp_disabled_uams -array “Cleartxt Passwrd” “MS2.0″ “2-Way Randnum exchange” sudo chmod o-w /Library/Preferences

Nach einem weiteren Neustart des Computers kann man auf die NAS-Laufwerke zugreifen.

Um das ganze wieder rückgängig zu machen verwendet man folgenden Befehl im Terminal:

sudo defaults write /Library/Preferences/com.apple.AppleShareClient afp_disabled_uams -array-add “DHCAST128″

Bisher habe ich noch kein Update für die Buffalo Linkstation Pro Duo entdeckt, lediglich diesen Forenbeitrag der Belegt, dass viele betroffen sind.

Update 26.07.2011

Hier gibt es einen unschönen Workarround um Backups mit der Timemachine zu erstellen. Dabei wird die alte Timemachine-App von Snow Leopard kopiert. Ich habe das nicht getestet. Inzwischen habe ich aber auch erste Updates auf den Support-Seiten gesehen, die evtl. den Fehler beheben,

Backup Backup

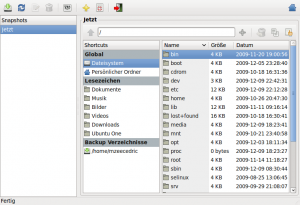

Muss gerade mein Backup sichern, weil die kürzlich erworbene NAS-Festpaltte Linkstation Pro Duo von Buffalo™ – bzw. deren Lüfter laut im Gehäuse schrabbt. Leider ist cyberport auch nicht wirklich kooperativ , d.h. ich habe keine Ersatzhardware bekommen. Somit muss ich meine aufwändig gesicherten Daten von der Linkstation wieder zurück auf irgendwelche Rechner und USB-Festplatten verteilen, danke! Dazu gehören auch die Backups von Back In Time, was unter Linux wohl ein kleiner Time Machine Ersatz ist. Was ich anfangs nicht beachtet habe ist, dass Back In Time bei den einzelnen Backups Hardlinks anlegt. Damit sollte man bei einer Sicherung der Verzeichnisse mit rsync nicht vergessen die Option -H zu setzen, um nicht die Datenmenge zu multiplizieren:

# rsync -aH /media/BackupDisk/backintime /home/user/backintime

Ich kann Back In Time als simples Backuptool unter Ubuntu empfehlen. Wer sich nicht tiefer mit rsync etcpp. auseinander setzen möchte, oder einfach komfortable mit einem Tool Backups erledigen will ist damit richtig.

Ubuntu – Image erstellen mit dd

Heute wurde wie geplant Ubuntu 9.10 (Karmic Koala) freigegeben. Wer wie ich einiges am Rechner herum gebastelt hat, tut gut vor dem Upgrade alle Daten zu sichern. Mit dem Befehl dd (Disk Dump) ist es recht einfach ein komplettes Image einer Festplatte zu erstellen.

Dazu benötigt man als erstes eine Live-CD von der man den Rechner startet. Es ist verständlicherweise nicht möglich eine Festplatte zu sichern auf die aktuell geschrieben wird. Jede ältere Ubuntu-CD sollte funktionieren. Nach dem Start sollte man nachsehen ob evtl. die zu sichernde Platte gemounted ist und diese ggfs unmounten.

Mit dem Befehl fdisk kann man sich einen Überblick über die Festplatte verschaffen:

~$ sudo fdisk -l

Außerdem sollte man nun eine weitere Festplatte mit ausreichend Speicherplatz zur Verfügung haben auf die man das Image schreiben kann. Eine externe Festplatte wäre z.B. eine Option. Achtung: Der Befehl dd überschreibt sofort ohne Rückfragen. Bei falscher Verwendung kann man sich natürlich seine Daten damit überschreiben:

dd if=Quelle of=Ziel <Optionen>

Um z.B. die Festplatte /dev/hda3 nach /Media/Data zu sichern verwendet man folgenden Befehl:

dd if=/dev/hda3 of=/Media/Data/hda3-image.img

Platzsparender wird das Image abgelegt wenn, man es mit gzip komprimiert:

dd if=/dev/hda3 | gzip -9 > /Media/Data/hda3-image.img.gz

Weitere Informationen findet man wie üblich sehr gut aufbereitet um Ubuntuusers-Wiki.

…und der Restore tut auch

Php5 auf Suse 10.0 unter Plesk 8.2 zu aktivieren scheint nicht ohne weiteres möglich. Nach einigem Suchen habe ich bei Host Europe in den FAQ’s eine Anleitung entdeckt. Damit ließ sich auch Php5 aktivieren, allerdings waren manche auf dem Server installierte WordPress Blogs nicht mehr aufrufbar und z.B. hier auf mzungu’s erhielt ich eine Alertbox mit der Meldung: „You’re not allowed to link directly to this .js file …“. Da ich den Grund für die Meldung spontan nicht finden konnte, beschloss ich einen Restore auf das zuvor angelegte Backup zu machen. Dass der Restore ca. eine Stunde dauert, hatte ich allerdings nicht erwartet! Inzwischen scheint alles wieder zu funktionieren *freu*.

Das MediaWiki benötigt in neuerer Version Php5, deshalb werde ich mich wohl in nächster Zeit nochmals um ein Update kümmern müssen. Am einfachsten wäre es natürlich wenn SWSoft ein Update inkl. Php5-Paket liefert.

WordPress automatisch aktualisieren

Wer gleichzeitig mehrere WordPress-Installationen upgraden möchte, kann dies elegant mit dem Shell-Skript von Alex Günsche erledigen. Voraussetzung dazu ist Shell-Zugriff und root-Rechte für den Server. Wer dies nicht zur Verfügung hat und nur eine einzelne Installation aktuell halten möchte, sollte das InstantUpgrade Plugin von Alex Günsche zu testen.

Das Skript lädt jeweils die aktuellste Version von WordPress herunter, entpackt diese und aktualisiert die angegebenen Verzeichnisse. Um das Skript zu verwenden sollte man allerdings genau wissen was man tut und vorher ein Backup erstellt haben. Ich habe es zudem zuerst an meiner Beta-Installation getestet. Folgende Schritte sind durchzuführen:

- Als Root einloggen und in das Verzeichnis /root/ wechseln (

# cd /root) - Ein Verzeichnis namens wpupgrade anlegen (

# mkdir wpupgrade) - In diesem Verzeichnis das Skript (s.u.) z.B. unter dem Namen

wpupdatespeichern - Das Skript mit ausführbar machen (

# chmod +x ./wpupdate) - Ein Verzeichnis mit allen benötigten Sprachdateien anlegen (

# mkdir languages)

Die aktuelle deutsche Sprachdatei findet man bei WordPress-Deutschland - Die Datei installations anlegen und dort die absoluten Pfade zu den einzelnen WordPress-Installationen und den Url folgendermaßen angeben:

/srv/www/vhosts/domain.de/httpdocs/=http://domain.de/

/srv/www/vhosts/domain2.de/httpdocs/=http://domain2.de/ - Das Skript ausführen (

# ./wpupdate)

Hier das Skript zum Download: wpupdate.

Hinweis: Das Skript funktioniert mit der aktuellen WordPress-Dateistruktur und ich habe es zum Update auf Version 2.2.1 verwendet. Bitte die Lizenzhinweise im Header beachten.

Update:

Beim Update der von mir verwalteten Weblogs habe ich einen Fehler beim chown der kopierten Dateien erhalten. Die neue WordPress-Version wird vom Skript mit den Berechtigungen des root-User kopiert. Deshalb müssen am Ende der Besitzer und die Gruppe korrigiert werden. Damit das Skript vollständig auf meinem Server mit einer Linux Suse 10.0 Installation und Plesk 8.2 funktioniert waren dazu folgende Anpassungen notwendig.

In Zeile 67 & 68:

USER=$(ls -l ${DIR}/wp-config.php | cut -f 4 -d ' ')

GROUP=$(ls -l ${DIR}/wp-config.php | cut -f 5 -d ' ')

In Zeile 86:

chown -R ${USER}:${GROUP} ${DIR}/*

Die Anpassungen in Zeile 67 & 68 bewirken, dass der richtige Benutzer und die richtige Gruppe zugeordnet werden. Mit der Anpassung in Zeile 86 wird festgelegt, dass nur Dateien innerhalb des WordPress Installationsverzeichnisses angepasst werden.

Um festzustellen ob tatsächlich der benötigte Benutzer und die richtige Gruppe eingesetzt wird, können folgende Befehle im WordPress-Verzeichnis ausgeführt werden. Dabei wird jeweils der Benutzer und die Gruppe ausgegeben:

# ls -l wp-config.php | cut -f 4 -d ' '

# ls -l wp-config.php | cut -f 5 -d ' '

Vielen Dank an Alex Günsche für den netten live Support bei der Anpassung an meine Bedürfnisse.

flickr Exit?

Flickr ist doof, hatten wir ja festgestellt. Aber allein diese Feststellung reicht nicht aus, wenn keine Konsequenzen folgen. Seit einigen Tagen habe ich einen Account bei Ipernity und es gefällt mir sehr gut dort.

Hier nun der Versuch meine flickr Bilder zu importieren:

Am besten schien mir das Greasemonkey Skript das Ipernity selber anbietet. Dazu muss die Greasemonkey-Erweiterung für Firefox installiert sein. Da nach kann man das Skript installieren und entdeckt unterhalb der Flickr Photos Seite (nach einigem suchen) den Mass-Importer. Es werden die Fotos inklusive Titel, Beschreibung, Datum, Lizenz und Freigabeeinstellungen, geografische Daten und bis zu 50 Tags importiert, – perfekt.

Am besten schien mir das Greasemonkey Skript das Ipernity selber anbietet. Dazu muss die Greasemonkey-Erweiterung für Firefox installiert sein. Da nach kann man das Skript installieren und entdeckt unterhalb der Flickr Photos Seite (nach einigem suchen) den Mass-Importer. Es werden die Fotos inklusive Titel, Beschreibung, Datum, Lizenz und Freigabeeinstellungen, geografische Daten und bis zu 50 Tags importiert, – perfekt.  Leider scheint flickr diesen Import derzeit zu verhindern, jedenfalls habe ich bei Ipernity nur einen netten Hinweis „This photo is currently unavailable.“ importiert. Alternativ kann man mit einem anderen Skript auch einzelne Bilder importieren. Das funktioniert, dauert aber einfach zu lange.

Leider scheint flickr diesen Import derzeit zu verhindern, jedenfalls habe ich bei Ipernity nur einen netten Hinweis „This photo is currently unavailable.“ importiert. Alternativ kann man mit einem anderen Skript auch einzelne Bilder importieren. Das funktioniert, dauert aber einfach zu lange.

Nächster Versuch war mit Flickr Backup, ein kleines Tool um die flickr Bilder auf die eigene Festplatte zu sichern. Sieht ganz gut aus und hat wohl auch gut funktioniert, aber ich erhalte nur die Meldung Backup Failed.

Erfolgreich war ich dann mit dem downloadr von Jan-Gerd Tenberge. Wenn man sich authentifiziert hat, kann man damit alle 200 Bilder von flickr herunterladen. Leider ist es damit nicht möglich alle Metadaten mitzunehmen. Deshalb habe ich auch die Bilder auch nicht wieder zu Ipernity hochgeladen. Um an ältere Bilder auf flickr zu kommen, müsste ich außerdem mit Löschen anfangen (oder natürlich einen Pro-Account kaufen). Das mit dem Löschen sollte man sich aber gut überlegen, schließlich sind viele Bilder im eigenen Blog verlinkt und die Urls müssten zu Ipernity aktualisiert werden.

Erfolgreich war ich dann mit dem downloadr von Jan-Gerd Tenberge. Wenn man sich authentifiziert hat, kann man damit alle 200 Bilder von flickr herunterladen. Leider ist es damit nicht möglich alle Metadaten mitzunehmen. Deshalb habe ich auch die Bilder auch nicht wieder zu Ipernity hochgeladen. Um an ältere Bilder auf flickr zu kommen, müsste ich außerdem mit Löschen anfangen (oder natürlich einen Pro-Account kaufen). Das mit dem Löschen sollte man sich aber gut überlegen, schließlich sind viele Bilder im eigenen Blog verlinkt und die Urls müssten zu Ipernity aktualisiert werden.

Derzeit hoffe ich auf eine Aktualisierung des Greasemonkey Skriptes und werde dann einen neuen Versuch starten.

Notiz: Think flickr, think!

Think flickr, think! Ganz heiß diskutiert wird gerade dass auf flickr Bilder für deutsche Nutzer zensiert werden:

flickr sperrt uns aus! Und auch dich!

Seit gestern werden für deutsche Nutzer keine Bilder mehr angezeigt, die als ‚moderate‘ oder ‚restricted‘ markiert sind! Es gibt keine Moeglichkeit das umzustellen – das ist eine grobe Unverschämtheit und Frechheit von flickr!

Aus dem Statement von flickr:

we do hear you loud and clearly (painfully loud, even) and are doing our best.

Seine Bilder kann man mit diesem Tool rausholen. Mit einem Pro-Account kein Problem, mit dem normalen bekommt man eben nur die letzten 200. Alternativen sind vielleicht sevenload oder zooomr oder selber hosten. Aber erst mal ruhig bleiben nicht paniken, flickr Account nicht gleich löschen, höchstens mal den flickr Pro Account nicht verlängern :).

[Loud and Clear via flickr-feeds, twitter, OGs Wohnzimmer 2 , Jared, usw.]

Datensicherung

Man sollte nicht erst die Daten verlieren, bevor man sich mit Datensicherung beschäftigt. Fotos, Filme, Ausarbeitungen, Emails, die Diplomarbeit, – schade wenn plötzlich alles futsch ist. Festplatten haben zwar in der Regel eine recht lange Lebensdauer, vor allem aber dann, wenn keine wichtigen Daten gespeichert wurden (vgl. Murphys Law). Also, ein Backup ist doch schnell gemacht… Datensicherung weiterlesen