In einem kleinen (unfreiwilligen) Selbstversuch habe ich gerade zwei Wochen lang den Google-Bot aus diesem Blog ausgesperrt. Das geht in WordPress recht einfach über die Option „Ich möchte Suchmaschinen blockieren, aber normale Besucher zulassen.“ unter Einstellungen › Privatsphäre. Diese hatte ich während meiner Übernahme des Blogs auf WordPress Multiuser eingestellt, damit die unter http://mzung.zungu.net importierten Seiten nicht unter dieser URL von Google indiziert werden. WordPress fügt dabei einen Metatag in den Seiten-Kopf ein, der verhindert, dass Google die Seiten durchsucht und im Suchindex speichert.

<meta name="robots" content="noindex, nofollow">

Nach dem meine Domain m.zung.us auf den neuen Ort des Blogs gemapped war, habe ich diese Einstellung schlicht vergessen zu entfernen.

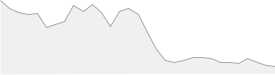

Ergebnis des Selbstversuchs: In 14 Tagen haben sich die Anzahl der Besucher auf genau 25% verringert.

In solchen Fällen sollte man nicht vergessen sich der Google Webmaster-Tools zu bedienen. Im Bereich der Crawl-Errors haben mich dort heute die über 1500 durch robots.txt ausgesperrten Seiten erschreckt. Ich bin gespannt wie bis wann (und ob) sich diese Zahlen wieder erholen. Seitens der Geschwindigkeit dürfte meine Seite sich durch die Nutzung von WP-Super-Cache verbessert haben, was Google nun auch als Kriterium im Ranking aufnimmt und zukünftig über die Webmaster-Tools supporten möchte, wie Golem berichtet. Einige Tipps zur Verbesserung der Performance habe ich ja auch schon kürzlich vorgenommen und dokumentiert.

Update: Hier noch der Verlauf der Indexierung von Google. Man sieht ganz genau dass Google die Indexierung umgehend eingestellt hat.